Berlin-Erst Anfang Oktober wurden zwei Forscher mit dem Physik-Nobelpreis geehrt, die sich mit komplexen Systemen befassen. Solche Systeme zeichneten sich durch Zufälligkeit und Unordnung aus und seien schwer zu verstehen, erklärte das Nobelkomitee. Einer der beiden Geehrten war der deutsche Klimaforscher Klaus Hasselmann, der ein Modell des Zusammenhangs der Erderwärmung mit den steigenden CO2-Emissionen entwickelt hatte. Doch nicht nur der Klimawandel ist ein komplexes Geschehen. Auch die Corona-Pandemie muss als solches betrachtet werden. Dies sei jedoch nicht geschehen, kritisiert der Astrophysiker Bernhard Müller, Professor an der Monash University in Australien.

Müller befasst sich normalerweise mit Supernova-Explosionen – auf der Basis komplexer Simulationen. In einer Streitschrift hat er sich nun auch mit der „Modellierung der Corona-Pandemie“ beschäftigt. Sie schließt sich einem Thesenpapier an, in dem jüngst eine achtköpfige Autorengruppe um den Kölner Mediziner Matthias Schrappe ein Konzept für das Verständnis der „Pandemie als komplexes System“ vorstellte.

Hoher Geltungsanspruch und Mangel an Selbstkritik

Wie schnell wird sich Sars-CoV-2 ausbreiten? Welche Maßnahmen zur Eindämmung sind angemessen und wirkungsvoll? Um solche Fragen ging es bei der Modellierung der Pandemie – also der Simulation des Pandemieverlaufs anhand von Modellen im Computer. Daraus wurden großenteils die Corona-Maßnahmen abgeleitet, bis hin zum sogenannten Lockdown. In Deutschland dominierten dabei Forschungsgruppen aus Göttingen, Braunschweig und Berlin.

Rückblickend schreibt Bernhard Müller: „Selten gab es in der Geschichte der Wissenschaft eine größere Spannung zwischen dem Geltungsanspruch und der politischen Wirkmächtigkeit von Vorhersagen und dem bemerkenswerten Mangel an Offenheit und Selbstkritik, wenn Vorhersagen sich nicht erfüllten.“ Darüber werde bisher nicht geredet. Mit seiner „Manöverkritik“ will der Astrophysiker der Öffentlichkeit nun einen Beitrag zu der Frage liefern, „was an den Modellen belastbar war, in deren Namen sie über Monate hinweg von der Exekutive dirigiert wurde“.

Dabei sollte man Folgendes sehen: Sars-CoV-2 hat als neuartiges, pandemisches Virus den Hang, sich immer weiter auszubreiten, sobald es auf noch nicht immunisierte Menschengruppen trifft. Dass hier Maßnahmen des Infektionsschutzes – Abstand, Hygienemaßnahmen, Masken, Tests, Quarantäne und auch Kontakteinschränkungen – notwendig sind, bestreiten ernstzunehmende Forscher nicht. Müller fragt vor allem, ob die Modelle den Pandemieverlauf auf belastbarer Grundlage vorhersagten – und ob aus ihnen stichhaltig härtere Lockdown-Maßnahmen begründet werden konnten.

Er hat große Zweifel daran. Wie er ausführt, seien relativ einfache Modelle genutzt worden, die der Komplexität des Geschehens nicht Rechnung trugen. Zudem seien die Modellierungen im Laufe der Pandemie nicht weiterentwickelt worden. Auch habe es keine Selbstkritik gegeben, nachdem Prognosen nicht in ihrer ganzen Dramatik eingetreten seien – und das, obwohl auf deren Grundlage zum Teil harte Maßnahmen beschlossen worden waren, die große wirtschaftliche und soziale Auswirkungen hatten. Eine Debatte darüber ist für Müller dringend notwendig, auch, damit die Wissenschaft künftig anders agiert.

Prognose des „exponentiellen Wachstums“ infrage gestellt

Konkret beginnt Müller bei den Prognosen eines „exponentiellen Wachstums“ Anfang 2020. Politiker und Medien rechneten damals immer wieder vor, dass ein Infizierter auf der Grundlage einer sogenannten Basisreproduktionszahl (R-Wert) jeweils eine bestimmte weitere Zahl von Menschen anstecke. Liege der R-Wert bei 3,0, dann infiziere eine Person drei Menschen, die nächste Generation neun, die übernächste 27 – und so weiter. Bis man in die Nähe der „Herdenimmunität“ komme. Im März 2020 wurden für die anrollende erste Welle allein in Deutschland bis zu zehn Millionen Infizierte und möglicherweise Hunderttausende Tote prognostiziert, falls nichts getan werde. Und in den Modellrechnungen wirkte sich vor allem ein Lockdown mit Kontaktverboten effektiv aus.

Müller kritisiert heute die damaligen Grundlagen. Er spricht von „Gleichungen auf dem Niveau der Mittelstufenmathematik“. Die verwendeten sogenannte SIR- und SEIR-Modelle beruhten auf einem Ansatz, der fast hundert Jahre alt sei. Zu den Modellannahmen gehört zum Beispiel, dass die Bevölkerung gut durchmischt ist, jeder mit jedem in Kontakt kommen kann und jeder etwa gleich anfällig für die Krankheit ist. Die Modelle rütteln nach Aussagen von Müller nicht viel am „naiven Bild vom exponentiellen Wachstum“. „Dass man so billig realistische Epidemie-Modelle bauen konnte, erschien von Anfang an suspekt, aber angesichts der Informationslage gewährte man der These vom drohenden exponentiellen Wachstum gern einen Vertrauensvorschuss.“

Der Pandemieverlauf habe dann aber bald gezeigt, dass die Realität wesentlich komplexer war. Nach dem Abklingen der ersten Welle habe man diskutiert, „wann und weshalb denn nun der berühmte R-Wert unter eins gesunken sei“. Die Begründung lautete: Die Maßnahmen gegen Corona hätten das exponentielle Wachstum gebrochen. „Das ist nachvollziehbar, denn eine Reduktion von Kontakten muss unstrittig das Infektionsgeschehen beeinflussen – aber es ist dennoch ein logischer Kurzschluss“, erklärt der Forscher.

Laut Müller sei nie belastbar nachgewiesen worden, welche Maßnahmen zu einem Abklingen der ersten Welle führten. Göttinger Modellierer stellten zwar im Juli 2020 dar, dass Kontaktbeschränkungen durch die Regierung die entscheidende Rolle spielten – was logisch erscheinen mag. Aber der Astrophysiker fand Ungereimtheiten, die „den Fachmann beunruhigen“. Und er entdeckte, dass in einer Folgeanalyse der Autoren – mit einem besseren Datensatz – der entscheidende Effekt verschwunden sei.

Müller kritisiert vor allem, dass die mit Modellierungen befassten Wissenschaftler nach der ersten überraschenden Entwicklung die Annahmen hinter ihren verwendeten Modellen nicht „schonungslos seziert“ und die Fachliteratur nicht nach ähnlichen Phänomenen durchforstet hätten. Doch die Epidemie-Modellierer „wurden dazu offenbar weder von der Politik angehalten noch taten sie es aus eigener Initiative noch fruchteten Nachfragen von Kollegen“.

Erhebliche Streuung in der Corona-Winterwelle 2020/21

Komplexere Modelle hätten zeigen können, dass Epidemien keineswegs bis zum Schluss exponentiell wachsen – auch ohne verfügte Kontaktbeschränkungen. Er selbst habe im Mai 2020 versucht, die erste Welle in Deutschland mit ein paar Annahmen über die Kontaktmuster der Bevölkerung zu reproduzieren, „ohne irgendeinen Effekt des Lockdowns vorauszusetzen“, erzählt Müller. Es sei eine „leichte Übung“ gewesen. Allerdings müsse man seine Modelle immer wieder mit Beobachtungsdaten konfrontieren und sie anhand der Daten anpassen. Anhaltspunkte gewinne man etwa, wenn man das Infektionsgeschehen genauer auflöse. Müller fand zum Beispiel für die Todeszahlen der Winterwelle 2020/21 „eine signifikante zeitliche Asynchronität in den einzelnen Landkreisen“, mit einer „erheblichen Streuung“. So etwas müsse man erklären.

Neben anderen Dingen vermutet Müller „natürliche Heterogenitätseffekte“ und „Abbremseffekte durch Cluster“, bei denen die Zahl der Neuinfektionen schneller abnimmt als erwartet. Solch ein Cluster-Modell skizziert der Astrophysiker selbst in seiner Arbeit. Es zeigt stark vereinfacht, dass sich eine Epidemie nicht gleichmäßig in der Bevölkerung ausbreitet, sondern in sogenannten Clustern – also zum Beispiel in Gemeinden, Pflegeheimen, Urlaubsorten, aber auch verstärkt in bestimmten Altersgruppen und Kontaktnetzwerken, die sich wiederum ständig ändern. Hinzu komme laut Müller, dass sich mancher aus unerfindlichen Gründen gar nicht infiziere, ein anderer aber lange und intensiv Virus ausscheide und zum Superspreader werde. Auch müsse man mit variablen Umweltfaktoren rechnen: UV-Strahlung, Temperatur, Feuchtigkeit und so weiter.

In komplexeren Modellen bedinge „die schnell steigende Wahrscheinlichkeit ‚verbrauchter‘ Folgekontakte eine schnelle Verlangsamung des Infektionsgeschehens“, schreibt Müller. Und er macht einige Vorschläge, wie man die komplexe Wirklichkeit besser abbilden könnte, in denen man etwa die Bevölkerung in mehr Untergruppen einteile als in den SIR-Modellen und die Reproduktionszahl durch eine Matrix ersetze, um zu beschreiben, wie häufig jemand aus Altersgruppe X jemanden aus Altersgruppe Y ansteckt, oder indem man die Menschen noch feiner nach der Anzahl ihrer Kontakte unterteile. In Müllers Darstellung fallen Fachbegriffe wie Reaktions-Diffusions-System, Renormierungsgruppentheorie, Theorie von Fraktalen, Bifurkationstheorie und dergleichen, die Laien kaum etwas sagen.

Vor allem brauche es mühsame Kleinarbeit, um sich der Wirklichkeit zu nähern, so Müller. Er gibt ein Beispiel, das sich auf den sogenannten R-Wert bezieht, also die Anzahl der Personen, die ein Infizierter im Durchschnitt angesteckt. „Wenn mein Modell sagt, dass der R-Wert gesunken ist, weil Kontakte außerhalb der Familie in der Freizeit verboten waren, dann sollte ich die tatsächlichen Ansteckungswege vor und nach den Kontaktbeschränkungen überprüfen – so etwas kann selbst der begabteste Theoretiker nicht vom Schreibtisch mit scharfsinnigen Rechnungen und Literaturrecherche bewerkstelligen.“ Erst der „Blick mit der Lupe“ könne wirklich robuste Erkenntnisse liefern. „Wenn man stattdessen einfach verfügbare Daten in eine automatisierte statistische Maschinerie wirft und die Wissensproduktion dem Computer überlässt, muss man auf Patzer gefasst sein.“

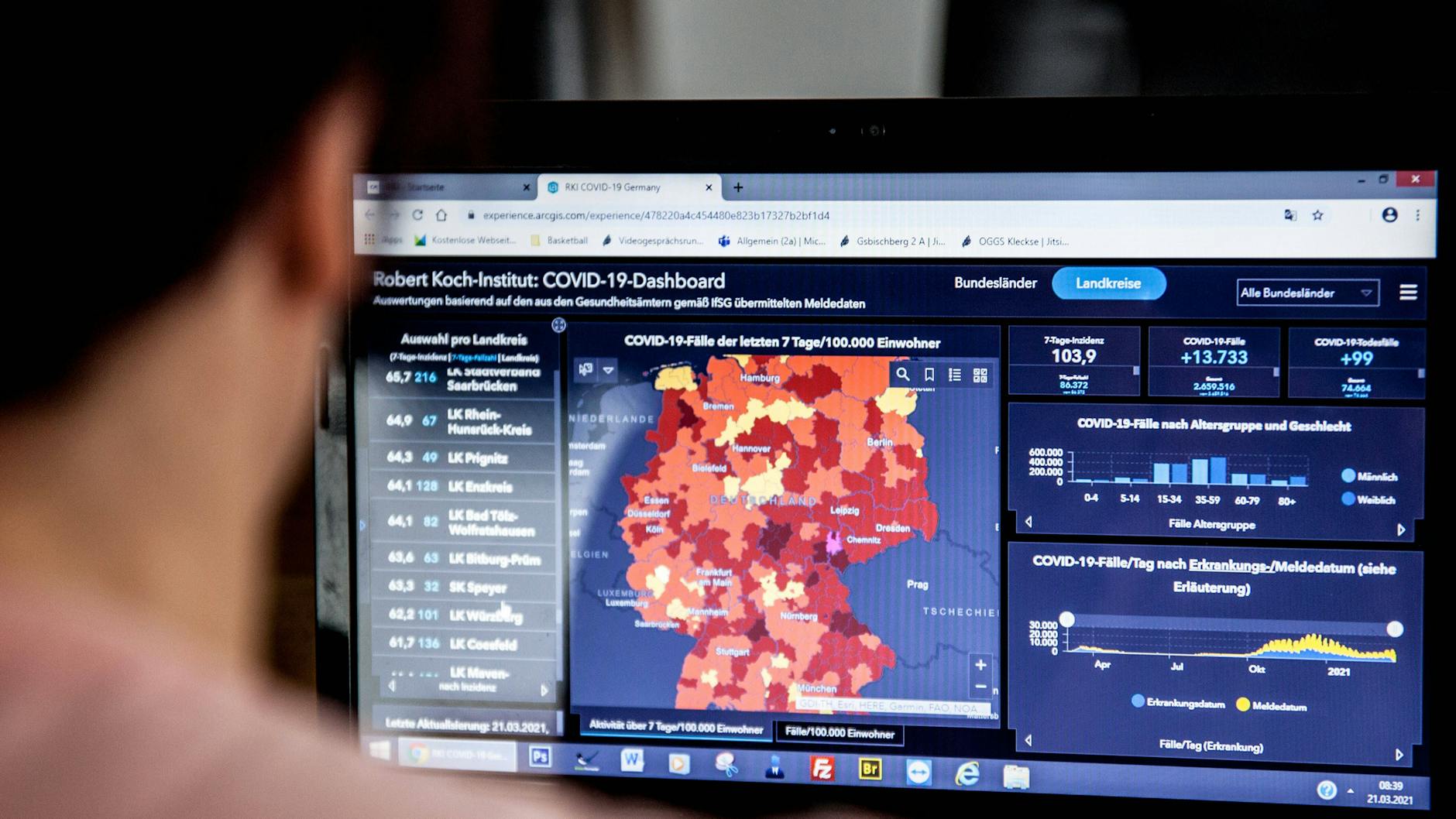

Kommission soll Modellierung der Corona-Pandemie untersuchen

Müller fordert eine Untersuchungskommission zur wissenschaftlichen Modellierung der Corona-Pandemie, die auch generell die Frage stelle: „Was können die Modelle wirklich und warum haben sie bisweilen weit am Ziel vorbeigeschossen? Was hat sich bestätigt, was hat sich als Fehleinschätzung erwiesen? Welche Fehler sind gemacht worden?“ Wie er ausführt, habe das Robert-Koch-Institut (RKI) in frühen Modellszenarien selbst Unsicherheitsfaktoren eingebaut, „um zu berücksichtigen, dass Cluster-Effekte die maximalen Infektionszahlen um einen gewissen Faktor reduzieren könnten“. Man habe also geahnt, dass man mit den Prognosen zu hoch liegen könnte. Irgendwann seien diese Unsicherheitsfaktoren aber verschwunden.

Besonders stößt sich der Astrophysiker an der Haltung der Pandemie-Modellierer selbst. Er schreibt: „Statt differenziert darzulegen, wo die Modelle nur qualitative Zusammenhänge illustrieren, wo sie quantitativ belastbar sein mögen, wo ihre Unsicherheiten und Grenzen liegen, hat man mit Intransigenz reagiert nach der Maxime: Die Simulationen sind zu glauben, und wenn sie nicht stimmen, dann ist es nicht unsere Schuld.“

Mehrfach habe man sich mit Modellen gründlich verschätzt, so Müller, zuletzt im Frühjahr 2021, als Berliner Forscher für Mai in Deutschland eine Sieben-Tage-Inzidenz von etwa 2000 Neuerkrankungen pro 100.000 Menschen prognostizierten. Selbst in Alternativszenarien habe die Inzidenz mit Werten um 500 um ein Mehrfaches über der späteren Realität gelegen. Dabei hätte ein Satz der Modellierer gereicht, um die Unsicherheiten zu zeigen, und zwar folgender: „Das Modell zeigt qualitativ den beschriebenen Effekt, aber die absoluten Zahlen können mit einer Unsicherheitsfaktor von fünf bis zehn behaftet sein.“